Wie Deregulierung, Drohnen und Digital-Oligarchen das 21. Jahrhundert entgleisen lassen

Ein Meinungsbeitrag von Günther Burbach.

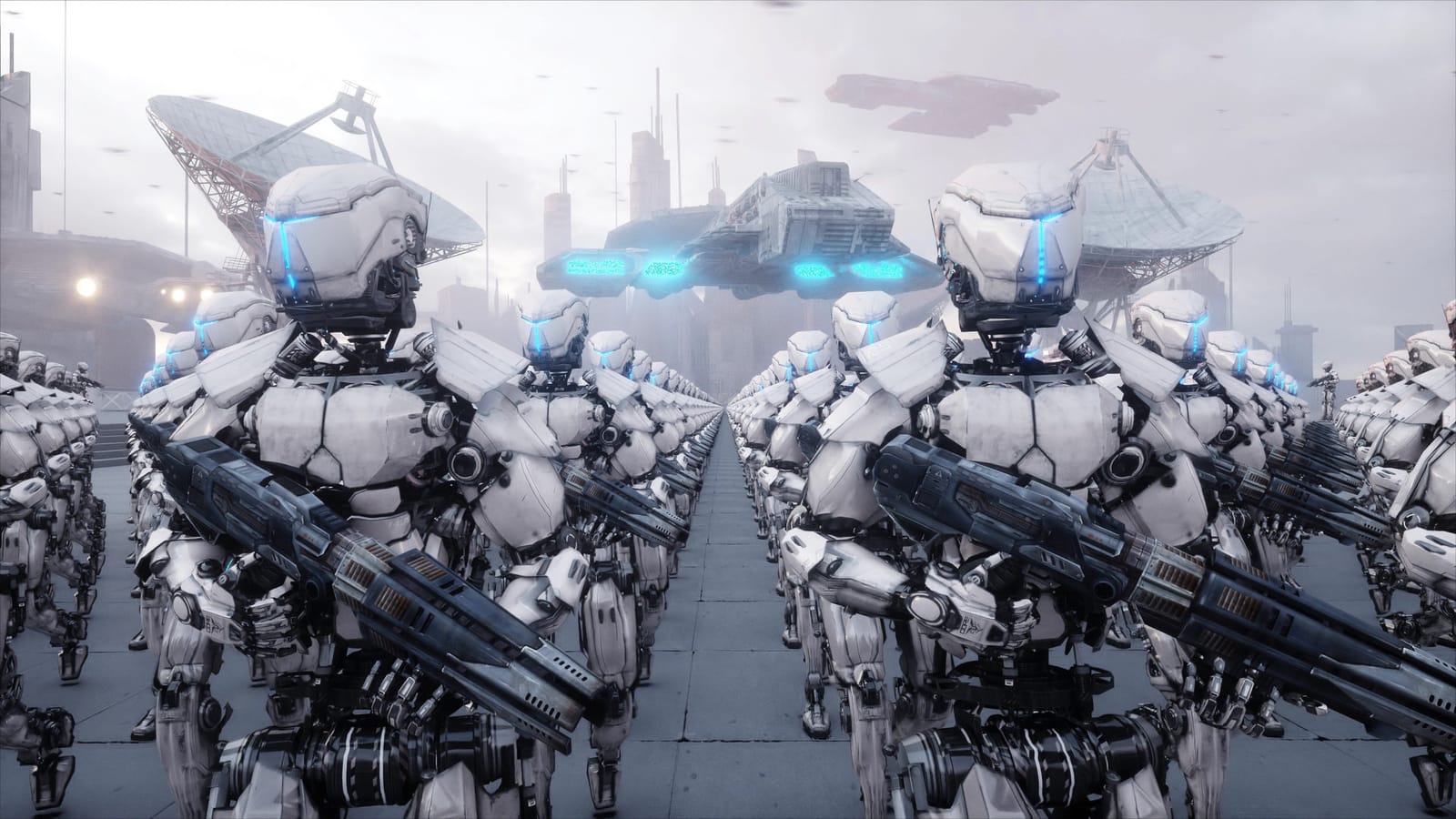

Stellen Sie sich eine Szene vor, die in keinem Science-Fiction-Film mehr spielt, sondern auf realen Kriegsfeldern unserer Zeit: Ein mechanischer Zwei-Meter-Roboter mit humanoider Silhouette marschiert durch ein zerbombtes Industrieviertel. Er erkennt Bewegungen hinter einer Mauer, scannt mit einem internen Wärmebildsensor den Raum, errechnet über ein neuronales Modul eine Bedrohungswahrscheinlichkeit von 78 Prozent und eröffnet das Feuer. Ohne Funkkontakt. Ohne Befehl. Ohne menschliches Zögern.

Noch ist dieses Bild Fiktion. Aber nicht mehr lange.

Denn die technologischen, politischen und ökonomischen Voraussetzungen, um solche Szenen Wirklichkeit werden zu lassen, sind längst geschaffen. Künstliche Intelligenz, Robotik und militärische Autonomisierung verschmelzen mit einer neuen Form der Macht, einer Macht, die sich nicht mehr über Staaten oder Verfassungen legitimiert, sondern über Serverfarmen, Satellitenkonstellationen und Deregulierungsdekrete.

Drei Entwicklungen greifen dabei ineinander wie Zahnräder eines Systems, das sich dem menschlichen Einfluss zunehmend entzieht:

- Die digitale Infrastruktur von Elon Musk, insbesondere das Satellitennetzwerk Starlink und der humanoide Tesla-Roboter „Optimus“, bildet bereits heute die Rückgratstruktur für militärische Kommunikation und Automatisierung in Konfliktzonen wie der Ukraine.

- Autonome Waffensysteme, vor allem Drohnen mit KI-Zielerkennung und Entscheidungsmodulen, sind nicht mehr Prototypen, sondern Realität auf dem Schlachtfeld, oft unbeachtet, oft unkontrolliert.

- Die politische Deregulierung von KI durch Donald Trump, konkretisiert in einer Executive Order vom Januar 2025, könnte ein regulatorisches Vakuum erzeugen, in dem Technologien ohne moralische Leitplanken global ausgerollt werden.

Was das bedeutet? Dass wir als Gesellschaft vor einem technologischen Umbruch stehen, der nicht nur unsere Arbeitswelt oder sozialen Medien betrifft, sondern die Grundfragen des Menschseins: Wer entscheidet über Leben und Tod? Wer trägt Verantwortung, wenn Algorithmen irren? Und was geschieht, wenn die Werkzeuge zur Macht bei jenen liegen, die sich keiner demokratischen Kontrolle mehr unterwerfen?

Dieser Artikel untersucht diese drei Entwicklungslinien nicht in ihrer theoretischen Möglichkeit, sondern in ihrer realen Umsetzung, mit belastbaren Quellen, technischen Beispielen und einer klaren Absicht: zu warnen, bevor es zu spät ist.

Denn während in Talkshows noch über Heizungsgesetze diskutiert wird, wird im Verborgenen eine neue Realität kodiert und sie kennt keine Rücktaste.

„Die Zukunft der Kriegsführung wird nicht vorbereitet – sie wird längst geprobt.“

Die digitale Kriegsmaschine – Wie Starlink und Musks Roboter die Front verändern

Wenn man heute von Elon Musk spricht, denken viele an Teslas, Raketenstarts oder meinetwegen an ein paar wirre Tweets. Was in der breiten Öffentlichkeit jedoch kaum ankommt: Musk ist längst ein Akteur im globalen Kriegsgeschehen, nicht metaphorisch, sondern ganz real. Und das nicht als Politiker oder General, sondern als Infrastrukturlieferant. Mit seinem Satellitennetzwerk Starlink hat er sich unbemerkt in eine Schlüsselposition katapultiert, die vormals nur Staaten vorbehalten war. Ohne Starlink wäre die ukrainische Armee digital weitgehend blind und das, obwohl offiziell weder die USA noch die NATO direkt im Einsatz stehen.

Starlink funktioniert im Kern wie ein digitales Nervensystem. Weltweit schwirren mittlerweile über 5.500 Satelliten im Orbit, Tendenz steigend. Musk will auf über 40.000 aufrüsten. Jeder dieser Satelliten ist Teil eines Netzes, das Bodenstationen mit Internet versorgt, unabhängig von Kabeln, Servern oder nationalen Telekom-Infrastrukturen. In der Ukraine wird Starlink seit 2022 militärisch eingesetzt. Zunächst hieß es noch, man wolle den zivilen Bereich stabilisieren. Doch längst dient das System zur Steuerung von Drohnen, zur Echtzeit-Kommunikation zwischen Front und Kommando und zur Koordination von Angriffen. Im Grunde ist Starlink das Rückgrat der digitalen Kriegsführung Kiews. Und Musk? Hat die Kontrolle über das Netz, technisch wie politisch.

Im Februar 2023 blockierte er erstmals bestimmte militärische Anfragen aus Kiew, etwa Angriffe auf russische Kriegsschiffe via Starlink-Daten. Das mag aus Sicht der Deeskalation vernünftig klingen, zeigt aber vor allem eines: Ein einzelner Unternehmer kann heute entscheiden, welche Armee kommunizieren darf und welche nicht. Man stelle sich vor, ein Telekommunikationsunternehmen hätte sich im Zweiten Weltkrieg entschieden, den Funkverkehr der Alliierten aus moralischen Gründen zu unterbinden. Undenkbar. Heute: Realität.

Parallel dazu läuft bei Tesla ein Projekt, das noch größere Fragen aufwirft: der humanoide Roboter „Optimus“. Noch wird er als smarter Helfer für Haushalt und Produktion vermarktet. Musk zeigte ihn auf der Bühne, wie er eine Kiste trägt, Schrauben sortiert, ein Ei in der Küche balanciert, der perfekte PR-Stunt. Doch was dieser 1,73 Meter große Roboter wirklich ist: eine Plattform. Wie ein Smartphone, auf das man jede App laden kann, nur mit Beinen, Greifhänden und 200 Newtonmeter Armkraft. Das Unternehmen verspricht, Optimus bald in Serie zu produzieren. Zehntausende Einheiten pro Jahr.

Offiziell soll er Pakete sortieren oder Senioren helfen. Aber wer die Technik kennt, weiß: Optimus kann auch laufen, balancieren, Gegenstände erkennen, Entscheidungen treffen. All das basiert auf neuronalen Netzen, auf maschinellem Lernen und auf Echtzeitdaten, die von Tausenden Kameras und Sensoren verarbeitet werden. Und sobald sich so ein System in einer Fabrik bewährt hat, warum nicht auch in einem Tunnel in Bachmut? Die Technologie macht keinen Unterschied zwischen Hausarbeit und Häuserkampf.

Entscheidend ist, was man der Software beibringt. Ein Reinigungsroboter erkennt, was schmutzig ist. Ein Kampfroboter erkennt, was gefährlich ist. Und wenn die Entscheidung, was gefährlich ist, einem lernenden System überlassen wird, dann sind wir nicht mehr weit davon entfernt, dass Maschinen eigenständig töten.

Man mag einwenden, das sei weit hergeholt. Noch sei Optimus nicht einsatzfähig. Noch sei das alles Zukunftsmusik. Doch der Punkt ist: In einem deregulierten Umfeld und genau das wird mit Trumps Politik (dazu später) jetzt massiv gefördert, dauert es eben nicht mehr 20 Jahre bis zur Marktreife, sondern vielleicht drei. Und in diesen drei Jahren testet ein Staat wie die Ukraine bereits KI-gesteuerte Drohnen im Echtbetrieb. Das ist kein Argument gegen die Ukraine. Es ist ein Argument gegen die Naivität, mit der wir technologische Realitäten betrachten.

Optimus muss nicht bewaffnet sein, um gefährlich zu werden. Es reicht, wenn er als autonomes System agiert, also ohne permanente menschliche Kontrolle. Schon die Frage, ob ein Roboter einen Soldaten aus dem Feuer ziehen oder ihn dem Feind ausliefern soll, kann über Leben und Tod entscheiden. Und niemand haftet, wenn etwas schiefläuft. Kein Offizier, kein Programmierer, kein Server.

Noch gravierender ist jedoch die Kombination der Systeme: Starlink bietet die digitale Infrastruktur, Optimus die physische Plattform. Dazu kommen KI-Modelle wie GPT-5 oder spezielle militärische Large Language Models (LLMs), die Entscheidungsschemata trainieren, aus Tausenden Szenarien und realen Kriegsdaten. Die Datenmengen, die Musk mit Optimus gewinnen will, könnten wiederum in das Training weiterer KI-Modelle einfließen. Und diese Modelle können dann, das ist keine Spekulation, sondern Stand der Entwicklung, Zielidentifikationen vornehmen, Risikoanalysen berechnen und operative Vorschläge ausgeben. In Echtzeit. Autonom.

Man muss nicht paranoid sein, um zu erkennen, was hier entsteht: Eine digital-militärische Maschinerie, die in Teilen bereits funktioniert und deren Vollautomatisierung längst angestoßen ist. Nicht durch Parlamente oder Generäle, sondern durch Tech-Giganten und Investoren.

Das Problem ist nicht, dass diese Technologie existiert. Das Problem ist, dass sie sich ihrer Kontrolle entzieht. Wenn ein Satellitennetzwerk wie Starlink über Kriegsverläufe mitentscheidet, wenn ein humanoider Roboter jederzeit umprogrammiert werden kann, wenn Algorithmen selbstständig Ziele priorisieren, dann ist das kein Fortschritt. Es ist ein Kipppunkt.

Die unsichtbare Waffe – Autonome Systeme und KI im Krieg: Testlauf Ukraine

Was früher nur auf Militärmessen gezeigt oder in Pentagon-Papieren durchgerechnet wurde, wird heute in Echtzeit getestet, auf ukrainischem Boden, oft unter völligem Ausschluss der Öffentlichkeit. Nicht nur Panzer, Raketen und westliche Waffentechnik fließen unablässig ins Kriegsgebiet, sondern auch eine neue Generation automatisierter Systeme: Drohnen, Roboter, Luftabwehrmodule, teils ausgestattet mit lernenden Algorithmen, teils vollständig autonom.

„Autonom“ heißt in diesem Zusammenhang nicht nur: ohne Fernbedienung. Es heißt: Ein System entscheidet selbstständig, ob etwas als Ziel erkannt wird, ob Gefahr besteht, ob es feuert, oder eben nicht.

Dass genau solche Technologien im Einsatz sind, bestätigen nicht nur Fachjournalisten und Analysten, sondern inzwischen auch westliche Rüstungspartner. Die Ukraine ist längst zu einem Testfeld für KI-gestützte Waffentechnik geworden. Was sich dort bewährt, wird später exportiert, entweder militärisch, wirtschaftlich oder politisch.

Ein besonders bekannter Fall ist der sogenannte „Saker Scout“, eine Drohne, die unter anderem in Partnerschaft mit britischen Entwicklern konzipiert wurde und mittlerweile mit einem KI-Modul ausgestattet ist, das mittels Deep Learning Bodenziele erkennen kann. Das System analysiert Infrarot- und Bilddaten aus der Luft, vergleicht sie mit Trainingsdaten aus früheren Einsätzen und kategorisiert, ob es sich um feindliche Stellungen, Fahrzeuge oder zivile Infrastruktur handelt. Die Trefferquote ist erschreckend hoch und die Fehlertoleranz besorgniserregend gering.

Sobald ein Objekt als potenzielles Ziel eingestuft wurde, kann die Drohne es entweder markieren, zur nachfolgenden Vernichtung durch Artillerie, oder direkt angreifen, wenn sie mit Sprengstoff bestückt ist. Menschliche Rückfrage? Nicht zwingend. Manche Systeme arbeiten in einem sogenannten „Fire-and-Forget“-Modus: Sie bekommen den groben Suchbereich vorgegeben, den Rest erledigt der Algorithmus.

Auch am Boden kommen erste autonome Systeme zum Einsatz. Das britische Verteidigungsministerium bestätigte bereits 2024 die Lieferung von „SkyKnight“-Systemen an die Ukraine, mobile Luftabwehrmodule mit KI-gestützter Zielerfassung. Das Prinzip: Ein 360°-Sensor-Radar analysiert die Flugbahn ankommender Objekte, die Software entscheidet, ob es sich um eine feindliche Drohne, einen Vogel oder einen eigenen Helikopter handelt und feuert im Bruchteil einer Sekunde. Gekoppelt ist das Ganze mit einem neuronalen Entscheidungsnetzwerk, das mit simulierten Gefechtsszenarien trainiert wurde.

Ähnliche Technologien wurden bereits in Israel mit der berühmten „Harop“-Drohne getestet, einer sogenannten „Loitering Munition“, also einer „herumlungernden Munition“, die bis zu 6 Stunden über einem Zielgebiet kreisen kann, bevor sie sich auf ein Ziel stürzt und es zerstört. Inzwischen arbeiten westliche und osteuropäische Rüstungsfirmen an vergleichbaren Konzepten. Die Steuerung wird dabei zunehmend automatisiert. Nicht mehr der Mensch entscheidet, wann der Angriff beginnt, sondern der Trainingsdatensatz.

Ein weiteres beunruhigendes Beispiel: Thermit-Drohnen, die mit brennbarem Metall gefüllt sind und gezielt gegnerische Stellungen in Brand setzen. Diese Drohnen, teilweise mit autonomen Zielalgorithmen ausgestattet, können ganze Schützengräben oder Versorgungslinien lahmlegen. Die thermische Zerstörung erfolgt großflächig und ist nur schwer zu löschen. Sie ist nicht präzise, nicht chirurgisch, sondern psychologisch brutal.

Wissenschaftlich begleitet werden diese Entwicklungen nur noch bedingt. Während Organisationen wie die Campaign to Stop Killer Robots oder das UNIDIR-Institut (UN Institute for Disarmament Research) seit Jahren vor autonomer Kriegsführung warnen, agieren Regierungen, insbesondere unter dem Druck aktueller Konflikte, im Graubereich. Die Ukraine gibt aus nachvollziehbaren Gründen kaum Informationen zu eingesetzten Systemen preis. Hersteller berufen sich auf Geschäftsgeheimnisse. Und westliche Unterstützer? Reden kaum darüber, oder nennen es „Innovation“.

Technisch basiert vieles auf sogenanntem Edge Computing, also Rechenleistung, die direkt im Gerät stattfindet, nicht mehr auf einem zentralen Server. Das macht Systeme schneller, reaktionsfähiger, aber auch weniger kontrollierbar. Ein Autopilot in einem Auto ist leicht nachzuverfolgen. Ein KI-Zielalgorithmus auf einem FPV-Drohnenchip, der in einem Schützengraben 300 km hinter der Front explodiert, ist es nicht.

Erst im Mai 2025 warnte ein Bericht des Centre for a New American Security (CNAS) vor genau dieser Entwicklung. Titel: “The Kill Chain Is Breaking Free“. Der Bericht analysiert, wie KI-Systeme zunehmend eigene Entscheidungsketten bilden, ohne menschliche Aufsicht. Die Autoren sprechen von einer „Erosion militärischer Verantwortlichkeit“ und „grundsätzlichen Herausforderungen für das Völkerrecht“. Einmal programmiert, sei der moralische Kompass der Maschine auf exakt das begrenzt, was ihr beigebracht wurde.

Und was passiert, wenn die Daten schlecht sind? Wenn das System Zivilisten mit Kombattanten verwechselt? Wenn ein Algorithmus eine Wärmesignatur als Bedrohung klassifiziert, weil ein ähnliches Muster zuvor zu einem Treffer geführt hat?

Verantwortung wird in diesen Fällen zur Blackbox. Niemand weiß, wie genau der Algorithmus zu seiner Entscheidung kam, man kann es im Nachhinein nur rekonstruieren. Wenn überhaupt.

Die Ukraine ist dabei nicht Täterin, sondern Bühne. Das Leid der Bevölkerung, der existentielle Verteidigungskampf, all das wird instrumentalisiert für die Entwicklung und Erprobung von Waffentechnik, die bald auch in anderen Konflikten eingesetzt werden könnte. Die USA, Großbritannien, Israel und private Rüstungskonzerne sehen in diesem Krieg nicht nur ein geopolitisches Projekt, sondern auch eine Möglichkeit zur beschleunigten Marktreife.

Was hier getestet wird, ist nicht weniger als der Übergang von der kontrollierten zur selbstentscheidenden Kriegsmaschine. Und die Folgen sind noch nicht absehbar.

Trumps Deregulierung – KI ohne Sicherheitsgurt

Wenn man heute von der Gefahr durch künstliche Intelligenz spricht, denken viele an Terminator-Fantasien oder an kluge Maschinen, die irgendwann einmal die Welt übernehmen könnten. Was jedoch fast niemand realisiert: Die rechtliche Grundlage, die verhindern soll, dass solche Systeme unkontrolliert zum Einsatz kommen, wird gerade im Eiltempo demontiert, vor allem in den USA. Und einer der wichtigsten Treiber dieser Entwicklung heißt Donald J. Trump.

Am 23. Januar 2025 unterzeichnete Trump, kaum drei Wochen nach Amtsantritt, ein Maßnahmenpaket, das in der Geschichte der US-Regulierung seinesgleichen sucht: die sogenannte „10-to-1 Executive Order“. Der Kern: Für jede neue staatliche Vorschrift müssen zehn bestehende Regelungen gestrichen werden. Das klingt nach Verwaltungsvereinfachung, ist aber in Wahrheit ein Generalangriff auf jede Form von staatlicher Aufsicht, insbesondere im Tech-Sektor.

Im begleitenden Fact Sheet des Weißen Hauses heißt es wörtlich:

„America will lead the world in artificial intelligence. Regulation must not be a brake on freedom and innovation.“ (Quelle: whitehouse.gov, 23.01.2025)

Was wie ein Innovationsversprechen klingt, bedeutet in der Praxis: KI-Systeme können künftig mit deutlich weniger behördlicher Prüfung entwickelt, veröffentlicht und sogar in militärische Kontexte überführt werden, ohne Ethikkommissionen, ohne Risikoanalyse, ohne transparente Standards.

Betroffen ist unter anderem der „Blueprint for an AI Bill of Rights“, ein Regelwerk der US-Regierung aus der Biden-Ära, das sensible KI-Anwendungen mit menschenrechtlichen Leitplanken versehen sollte. Dieses Dokument, bereits nie rechtsverbindlich, wurde von Trumps Beratern sofort als „Wachstumsbremse“ eingestuft. Auch Richtlinien der Defense Innovation Unit, die autonome Systeme im Verteidigungsbereich kritisch begleiten sollte, stehen zur Streichung.

Was das konkret heißt? Dass militärisch nutzbare KI, etwa zur Zielauswahl, Mustererkennung oder Entscheidungsunterstützung, künftig ohne jede Pflicht zur Nachvollziehbarkeit entwickelt werden darf. Und das geschieht nicht im luftleeren Raum. Große Konzerne wie Palantir, Anduril, Lockheed Martin oder auch OpenAI (militärischer Zweig) stehen längst bereit, um sogenannte „predictive targeting modules“ in Drohnensysteme oder Command-and-Control-Plattformen einzubauen.

Technisch gesehen bedeutet das: Sprachmodelle wie GPT-5 (und dessen militärische Varianten) können auf Befehl ganze Einsatzszenarien simulieren, mögliche Ziele priorisieren und auf Basis großer Datensätze taktische Entscheidungen empfehlen, oder sogar direkt in Entscheidungsprozesse eingreifen.

Ein Beispiel: Ein KI-System analysiert die letzten 72 Stunden feindlicher Bewegungen, erkennt Muster in der Verlegung schwerer Artillerie, erstellt eine Wahrscheinlichkeitskarte für den nächsten Angriff und generiert auf dieser Basis einen Vorschlag, welche Koordinaten mit Präzisionswaffen zu beschießen sind. Ohne menschliche Beurteilung, ohne Kontextwissen, nur auf Grundlage mathematischer Gewichtung. Die Entscheidung zum Angriff liegt dann entweder bei einem übermüdeten Kommandeur, oder, in Zukunft, beim System selbst.

Trump selbst äußerte sich zu diesem Thema auf einer Wahlkampfveranstaltung im März 2025 folgendermaßen:

„Wir brauchen keine linken Moralregeln für Maschinen. Wir brauchen Ergebnisse. Amerika darf nicht verlieren, weil Bürokraten Angst vor der Zukunft haben.“

Sein Ziel ist klar: Technologieführerschaft um jeden Preis. Die Risiken? Werden ignoriert. Die ethischen Debatten? Als „linksradikale Panikmache“ abgetan.

Und das ist gefährlich, weil die Kombination aus Deregulierung und militärischem Interesse ein explosives Gemisch ist. Unternehmen, die bislang aufgrund regulatorischer Hürden zögerten, Systeme mit höherem Autonomiegrad auf den Markt zu bringen, sehen sich nun ermutigt. Die moralische Verantwortung wird an den Kunden ausgelagert, oder direkt ins Produkt eingebaut.

Ein interner Report des Center for Humane Technology, der im Februar 2025 geleakt wurde, warnt eindringlich:

„Wenn das regulatorische Sicherheitsnetz verschwindet, entsteht ein globaler Wildwuchs algorithmischer Gewalt. Wer zuerst deployed, gewinnt und wer warnt, verliert Marktanteile.“

Besonders brisant: Diese Entwicklungen passieren zeitgleich mit massiven Investitionen in KI-Infrastruktur, unter anderem durch das sogenannte Stargate-Projekt, ein 500-Milliarden-Dollar-Konsortium aus OpenAI, Oracle und SoftBank, das eine neue, weltumspannende KI-Infrastruktur aufbaut. Ziel: 100.000 H100-GPUs, verteilt über zehn Megazentren, gesteuert durch ein eigenes Quasi-Internet. Eine technische Machtfülle, die jeden nationalen Gesetzgeber vor sich hertreibt.

Noch gibt es internationale Gremien, die sich mit diesen Entwicklungen beschäftigen, wie etwa die UNESCO. Doch deren Einfluss ist begrenzt. Und solange eine Weltmacht wie die USA aktiv dereguliert, werden alle anderen gezwungen, mitzuziehen, oder sich vom globalen Wettbewerb abzukoppeln.

Am Ende steht eine Entwicklung, die vielleicht mit besten Absichten begann, aber nun außer Kontrolle gerät: Maschinen, die selbstständig denken, handeln, töten. Gefördert durch politische Kurzsichtigkeit, ökonomischen Druck und die Bereitschaft, ethische Prinzipien dem Fortschrittsglauben zu opfern.

Ausblick & Warnung – Wenn das System entscheidet und keiner mehr stoppt

Es beginnt nicht mit Explosionen. Es beginnt mit Schnittstellen. Mit einem Satelliten, der Daten überträgt. Mit einer Drohne, die entscheidet, ob ein Objekt als Bedrohung zu klassifizieren ist. Mit einem Roboter, der sich nicht mehr umdreht, wenn jemand schreit.

Was wir in den vergangenen Monaten sehen und in diesem Artikel beschrieben haben, ist kein technischer Fortschritt im klassischen Sinn. Es ist eine Machtverschiebung. Weg vom Menschen. Weg von Verantwortung. Hin zu Maschinen, die mit jeder Entscheidung mehr über uns wissen, mehr über uns lernen und irgendwann entscheiden, was mit uns geschieht.

Diese Entwicklung hat drei Gesichter:

Das erste heißt Elon Musk, oder besser: das, was er repräsentiert. Nicht nur ein Mann mit Satelliten und Robotern, sondern ein Tech-Komplex, der sich vom Primat der Politik emanzipiert hat. Wer heute über Kriegsverläufe entscheiden kann, indem er die Verbindungsdaten filtert oder seinen Dienst abschaltet, der hat mehr Macht als ein Parlament. Und wer gleichzeitig Roboter bauen lässt, die laufen, greifen, handeln, dann aber sagt, es handle sich um Haushaltshilfen, der sagt vielleicht nicht die ganze Wahrheit.

Das zweite Gesicht heißt: autonome Waffen. Was einst mit ferngesteuerten Raketen begann, ist heute ein selbstlernendes System, das auf Basis von Zielbildern, Musterdaten und Rechenmodellen entscheidet, wo geschossen wird. Die Ukraine zeigt uns, wie solche Technik „im Ernstfall“ funktioniert. Und sie zeigt auch, wie still diese Schwelle überschritten wurde. Ohne Debatte. Ohne Mandat. Ohne Plan B.

Das dritte Gesicht ist Donald Trump und das, was seine Politik weltweit auslöst: den Verlust jeder Schranke. Wenn Vorschriften fallen, weil sie „Innovation bremsen“, wenn KI-Forschung keine ethische Aufsicht mehr braucht, wenn riesige Modelle gebaut werden dürfen, die niemand mehr vollständig versteht, dann ist das kein Vorsprung. Das ist Kontrollverlust in Echtzeit.

Was also folgt daraus?

Vielleicht nicht sofort der große Systemzusammenbruch. Vielleicht auch nicht der Marsch der Maschinen. Aber eine permanente Entwertung menschlicher Entscheidung. Eine langsame Erosion von Verantwortung, von Rechtsstaatlichkeit, von Transparenz. Und irgendwann eine neue Normalität: dass nicht mehr gefragt wird, ob ein System töten darf, sondern nur noch, wie zuverlässig es dabei ist.

Das Tragische: Wir haben all das kommen sehen. Wir haben Filme darüber gemacht, Bücher geschrieben, Forschungsprojekte aufgelegt. Doch jetzt, wo es konkret wird, wo Menschen in Kiew via Starlink Drohnen fliegen, in Texas humanoide Roboter in Serie gehen und in Washington der regulatorische Not-Aus entfernt wird, da schauen wir lieber auf Wahlumfragen, auf Fußballspiele, auf die Inflation.

Aber wer jetzt wegsieht, wird später nicht sagen können, er habe es nicht gewusst.

Die gute Nachricht: Noch ist Zeit. Zeit, über KI zu sprechen, nicht nur im Silicon-Valley-Jargon, sondern politisch, rechtlich, ethisch. Zeit, echte Regeln zu formulieren, global, verbindlich, transparent. Zeit, Verantwortung zurückzufordern, von jenen, die sie algorithmisch abgeschoben haben.

Doch diese Zeit wird knapp. Denn Maschinen haben keine Geduld. Sie rechnen einfach weiter.

Schlussappell:

Wir leben nicht in einer Dystopie. Noch nicht. Aber wir steuern auf eine zu, wenn wir weiterhin glauben, dass Fortschritt per se gut ist, dass Technik neutral ist, dass Systeme klüger sind als Menschen. Vielleicht ist jetzt der Moment gekommen, nicht mehr nur zu staunen, sondern endlich zu widersprechen. Denn wer schweigt, wenn Maschinen töten lernen, macht sich mitschuldig.

Quellen und Anmerkungen

I. Trumps Deregulierungspolitik

Quelle 1: White House (Amtssitz des US-Präsidenten), Veröffentlicht am 23. Januar 2025

https://www.whitehouse.gov/fact-sheets/2025/01/fact-sheet-president-donald-j-trump-launches-massive-10-to-1-deregulation-initiative/

Quelle 2: White House, Veröffentlicht am 23. Januar 2025

https://www.whitehouse.gov/presidential-actions/2025/01/unleashing-prosperity-through-deregulation/

II. Autonome Waffensysteme im Ukraine-Krieg

Quelle 3: Forbes (US-Wirtschaftsmagazin), Veröffentlicht am 17. Oktober 2023 https://www.forbes.com/sites/davidhambling/2023/10/17/ukraines-ai-drones-seek-and-attack-russian-forces-without-human-oversight/

Quelle 4: Automated Decision Research (Forschungsplattform für autonome Systeme), Abrufbar seit 2024

https://automatedresearch.org/weapon/saker-scout-uav/

Quelle 5: UNITED24 Media (offizielles ukrainisches Medienprojekt unter Präsidentschaft von Wolodymyr Selenskyj), Veröffentlicht am 14. April 2024

https://united24media.com/war-in-ukraine/ai-powered-turret-that-hunts-russian-drones-meet-sky-sentinel-ukraines-new-air-defense-8589

Quelle 6: Wikipedia (nur zur technischen Einordnung verwendet – nicht als Primärquelle!), Stand: abgerufen Mai 2025

https://en.wikipedia.org/wiki/IAI_Harop

Quelle 7: „Investing in Great-Power Competition“ (CNAS)

https://www.cnas.org/publications/reports/investing-in-great-power-competition

III. Elon Musk, Starlink und Robotik

Quelle 8: Financial Times (britische Wirtschaftszeitung), Veröffentlicht am 21. Januar 2025

https://www.ft.com/content/a9cd130f-f6bf-4750-98cc-19d87394e657

Quelle 9: TechCrunch (US-Technachrichtenplattform), Veröffentlicht am 21. Januar 2025

https://techcrunch.com/2025/01/21/openai-teams-up-with-softbank-and-oracle-on-50b-data-center-project/

Quelle 10: OpenAI (offizielle Firmenwebsite), Veröffentlicht am 21. Januar 2025

https://openai.com/index/announcing-the-stargate-project/

Quelle 11: Times of India (indische Tageszeitung, Technologieressort), Veröffentlicht am 28. Februar 2025

https://timesofindia.indiatimes.com/technology/social/elon-musk-provides-an-update-on-teslas-optimus-robot-there-will-be-a/articleshow/119912214.cms

Quelle 12: The Sun (britisches Boulevardblatt, Technik-Rubrik), Veröffentlicht am 16. März 2025

https://www.thesun.co.uk/tech/31012254/moment-elon-musk-reveals-tesla-optimus-robots/

+++

Wir danken dem Autor für das Recht zur Veröffentlichung dieses Beitrags.

+++

Bild: bewaffnete humanoide Roboter

Bildquelle: Pavel Chagochkin / shutterstock

+++

Ihnen gefällt unser Programm? Machen wir uns gemeinsam im Rahmen einer "digitalen finanziellen Selbstverteidigung" unabhängig vom Bankensystem und unterstützen Sie uns bitte mit der:

Spenden-Kryptowährung „Nackte Mark“: https://apolut.net/unterstuetzen/#nacktemark

oder mit

Bitcoin: https://apolut.net/unterstuetzen#bitcoin

Informationen zu weiteren Unterstützungsmöglichkeiten finden Sie hier: https://apolut.net/unterstuetzen/

+++

Bitte empfehlen Sie uns weiter und teilen Sie gerne unsere Inhalte in den Sozialen Medien. Sie haben hiermit unser Einverständnis, unsere Beiträge in Ihren eigenen Kanälen auf Social-Media- und Video-Plattformen zu teilen bzw. hochzuladen und zu veröffentlichen.

+++

Abonnieren Sie jetzt den apolut-Newsletter: https://apolut.net/newsletter/

+++

Unterstützung für apolut kann auch als Kleidung getragen werden! Hier der Link zu unserem Fan-Shop: https://harlekinshop.com/pages/apolut